![]()

Dieser Artikel entstand, nachdem ich eine Online-Diskussion darüber verfolgt hatte, ob ein 35-mm- oder ein 50-mm-Objektiv an einer Vollformatkamera das gleiche Sichtfeld bietet wie das normale menschliche Sehen. In dieser Diskussion ging es sofort um die optische Physik des Auges als Kamera und Objektiv – ein verständlicher Vergleich, da das Auge aus einem vorderen Element (der Hornhaut), einem Blendenring (der Iris und der Pupille), einer Linse und einem Sensor (der Netzhaut) besteht.

Trotz all der beeindruckenden Mathematik, die in Bezug auf die optische Physik des Augapfels hin und her geworfen wurde, schien die Diskussion logisch keinen Sinn zu ergeben, also habe ich selbst viel zu diesem Thema gelesen.

Dieser Artikel wird Ihnen keinen direkten Nutzen bringen, der Sie dazu bringt, loszulaufen und bessere Fotos zu machen, aber vielleicht finden Sie ihn interessant. Vielleicht finden Sie ihn aber auch unglaublich langweilig, deshalb gebe ich Ihnen zuerst meine Schlussfolgerung in Form von zwei Zitaten von Garry Winogrand:

Ein Foto ist die Illusion einer wörtlichen Beschreibung, wie die Kamera ein Stück Zeit und Raum „gesehen“ hat.

Fotografie handelt nicht von der fotografierten Sache. Es geht darum, wie die fotografierte Sache aussieht.

Im Grunde habe ich bei all meinen Nachforschungen darüber, wie das menschliche Auge einer Kamera gleicht, gelernt, dass das menschliche Sehen nicht wie eine Fotografie ist. In gewisser Weise erklärte es mir, warum ich ein Foto so oft viel schöner und interessanter finde als die eigentliche Szene.

Das Auge als Kamerasystem

![]()

Oberflächlich betrachtet ist es ziemlich logisch, das Auge mit einer Kamera zu vergleichen. Wir können die Länge des Auges von vorne nach hinten (etwa 25 mm von der Hornhaut bis zur Netzhaut) und den Durchmesser der Pupille (2 mm zusammengezogen, 7 bis 8 mm geweitet) messen und daraus linsenähnliche Werte berechnen.

Für die Brennweite des Auges werden jedoch unterschiedliche Werte angegeben. Einige beruhen auf physikalischen Messungen der anatomischen Strukturen des Auges, andere auf optometrischen Berechnungen, wieder andere berücksichtigen, dass sich die Augenlinse und die Augengröße selbst durch die Kontraktion verschiedener Muskeln verändern.

Zusammenfassend lässt sich jedoch sagen, dass eine häufig angegebene Brennweite des Auges 17 mm beträgt (sie wird aus dem optometrischen Dioptrienwert berechnet). Der allgemein akzeptierte Wert ist jedoch 22mm bis 24mm (berechnet aus der physikalischen Refraktion im Auge). In bestimmten Situationen kann die Brennweite sogar länger sein.

Da wir die ungefähre Brennweite und den Durchmesser der Pupille kennen, ist es relativ einfach, die Blende des Auges zu berechnen. Bei einer Brennweite von 17 mm und einer Pupille von 8 mm sollte der Augapfel als f/2,1-Objektiv funktionieren. Bei einer Brennweite von 24 mm und einer Pupille von 8 mm müsste es f/3,5 sein. In der Astronomie wurde eine Reihe von Studien durchgeführt, um die Blende des menschlichen Auges zu messen, und die gemessene Zahl liegt bei f/3,2 bis f/3,5 (Middleton, 1958).

![]()

An dieser Stelle haben sich wahrscheinlich alle, die bis hierher gelesen haben, gefragt: „Wenn die Brennweite des Auges 17 oder 24 mm beträgt, warum streiten dann alle darüber, ob 35-mm- oder 50-mm-Objektive das gleiche Sichtfeld wie das menschliche Auge haben?“

Der Grund dafür ist, dass die gemessene Brennweite des Auges nicht ausschlaggebend für den Sichtwinkel des menschlichen Sehens ist. Darauf werde ich weiter unten noch näher eingehen, aber der Hauptpunkt ist, dass nur ein Teil der Netzhaut das Hauptbild verarbeitet, das wir sehen. (Der Bereich des Hauptsehens wird als Kegel der visuellen Aufmerksamkeit bezeichnet, der Rest dessen, was wir sehen, ist „peripheres Sehen“).

Studien haben den Kegel der visuellen Aufmerksamkeit gemessen und festgestellt, dass er etwa 55 Grad breit ist. Bei einer 35-mm-Vollformatkamera bietet ein 43-mm-Objektiv einen Blickwinkel von 55 Grad, so dass diese Brennweite genau dem Blickwinkel entspricht, den wir Menschen haben. Verdammt, wenn das nicht auf halbem Weg zwischen 35 mm und 50 mm liegt. Damit ist die ursprüngliche Diskussion beendet, denn das „normale“ Objektiv einer Kleinbild-Spiegelreflexkamera hat weder 35 mm noch 50 mm, sondern liegt auf halbem Weg dazwischen.

Das Auge ist kein Kamerasystem

Nachdem ich die Antwort auf die ursprüngliche Diskussion erhalten hatte, hätte ich die Sache auf sich beruhen lassen und mit einem weiteren ziemlich nutzlosen Wissensschatz davonkommen können, mit dem ich meine Online-Freunde verblüffen kann. Aber NOOoooo. Wenn ich einen Haufen Arbeit zu erledigen habe, ziehe ich es fast immer vor, noch ein paar Stunden damit zu verbringen, weitere Artikel über das menschliche Sehen zu lesen.

Sie haben vielleicht bemerkt, dass im obigen Abschnitt einige der Analogien zwischen Auge und Kamera ausgelassen wurden, denn wenn man über die einfachen Messungen von Blende und Linse hinausgeht, passen die restlichen Vergleiche nicht mehr so gut.

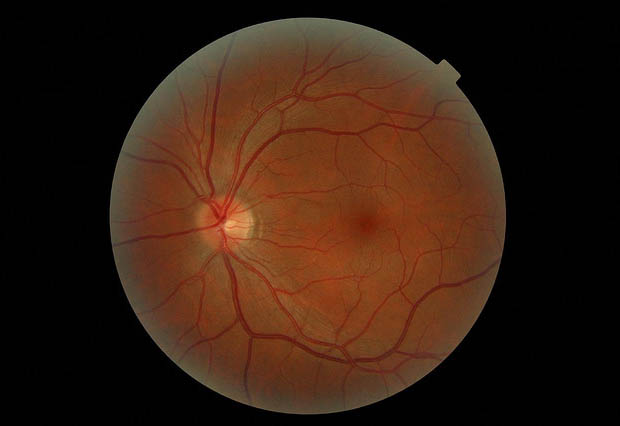

Betrachten Sie den Sensor des Auges, die Netzhaut. Die Netzhaut hat fast die gleiche Größe (32 mm Durchmesser) wie der Sensor einer Vollformatkamera (35 mm Durchmesser). Danach ist jedoch fast alles anders.

Der erste Unterschied zwischen der Netzhaut und dem Sensor Ihrer Kamera ist ziemlich offensichtlich: Die Netzhaut ist entlang der Rückseite des Augapfels gekrümmt, nicht flach wie der Siliziumsensor in der Kamera. Die Krümmung hat einen offensichtlichen Vorteil: Die Ränder der Netzhaut sind etwa gleich weit vom Objektiv entfernt wie die Mitte. Bei einem flachen Sensor sind die Ränder weiter von der Linse entfernt und die Mitte näher. Vorteil Netzhaut – sie sollte eine bessere „Eckenschärfe“ haben.

Das menschliche Auge hat auch viel mehr Pixel als Ihre Kamera, etwa 130 Millionen Pixel (fühlen Sie sich als Besitzer einer 24-Megapixel-Kamera jetzt bescheiden?). Allerdings sind nur etwa 6 Millionen der Pixel des Auges Zapfen (die Farbe sehen), die restlichen 124 Millionen sehen nur schwarz und weiß. Aber wieder ein Vorteil für die Netzhaut.

Aber wenn wir weiter schauen, werden die Unterschiede noch deutlicher…

Auf einem Kamerasensor ist jedes Pixel in einem regelmäßigen Gittermuster angeordnet. Jeder Quadratmillimeter des Sensors hat genau die gleiche Anzahl und das gleiche Muster von Pixeln. Auf der Netzhaut gibt es einen kleinen zentralen Bereich mit einem Durchmesser von etwa 6 mm (die Makula), der die dichteste Konzentration von Fotorezeptoren im Auge enthält. Der zentrale Teil der Makula (die Fovea) ist dicht mit Zapfenzellen (Farbsinneszellen) besetzt. Der Rest der Makula um diesen zentralen Bereich herum enthält sowohl Stäbchen als auch Zapfen.

![]()

Die Makula enthält etwa 150.000 „Pixel“ in jedem 1mm-Quadrat (vergleichen Sie das mit 24.000.000 Pixeln auf einem 35mm x 24mm-Sensor in einer 5DMkII oder D3x) und sorgt für unser „zentrales Sehen“ (der oben erwähnte 55-Grad-Kegel der visuellen Aufmerksamkeit). Wie auch immer, der zentrale Teil unseres Gesichtsfeldes hat ein weitaus höheres Auflösungsvermögen als selbst die beste Kamera.

Der Rest der Netzhaut hat weit weniger „Pixel“, von denen die meisten nur schwarz-weiß sind. Er sorgt für das, was wir gewöhnlich als „peripheres Sehen“ bezeichnen, also für die Dinge, die wir „im Augenwinkel“ sehen. Dieser Teil nimmt bewegte Objekte sehr gut wahr, bietet aber nicht genug Auflösung, um z. B. ein Buch zu lesen.

Das gesamte Sichtfeld (der Bereich, in dem wir Bewegungen sehen können) des menschlichen Auges beträgt 160 Grad, aber außerhalb des visuellen Aufmerksamkeitskegels können wir nicht wirklich Details erkennen, sondern nur grobe Formen und Bewegungen.

Die Vorteile des menschlichen Auges gegenüber der Kamera verringern sich ein wenig, wenn wir die Netzhaut verlassen und zurück zum Gehirn reisen. Die Kamera sendet die Daten jedes einzelnen Pixels vom Sensor an einen Computerchip, der sie zu einem Bild verarbeitet. Das Auge hat 130 Millionen Sensoren in der Netzhaut, aber der Sehnerv, der die Signale dieser Sensoren an das Gehirn weiterleitet, hat nur 1,2 Millionen Fasern, so dass zu jedem Zeitpunkt weniger als 10 % der Daten der Netzhaut an das Gehirn weitergeleitet werden. (Das liegt zum Teil daran, dass die chemischen Lichtsensoren in der Netzhaut eine Weile brauchen, um sich nach der Stimulation wieder aufzuladen“. Zum anderen, weil das Gehirn ohnehin nicht so viele Informationen verarbeiten könnte.)

![]()

Und natürlich verarbeitet das Gehirn die Signale ganz anders als eine Fotokamera. Im Gegensatz zu den intermittierenden Auslöser-Klicks einer Kamera sendet das Auge dem Gehirn ein konstantes Video, das zu dem verarbeitet wird, was wir sehen. Ein unterbewusster Teil des Gehirns (der Nucleus geniculatus lateralis, wenn Sie es wissen müssen) vergleicht die Signale von beiden Augen, setzt die wichtigsten Teile zu 3-D-Bildern zusammen und sendet sie an den bewussten Teil des Gehirns zur Bilderkennung und weiteren Verarbeitung.

Das unterbewusste Gehirn sendet auch Signale an das Auge und bewegt den Augapfel leicht in einem Abtastmuster, so dass sich die scharfe Sicht der Makula über ein Objekt von Interesse bewegt. In einigen Sekundenbruchteilen sendet das Auge tatsächlich mehrere Bilder, die das Gehirn zu einem vollständigeren und detaillierteren Bild verarbeitet.

Das unterbewusste Gehirn weist auch einen Großteil der eingehenden Bandbreite zurück und sendet nur einen kleinen Teil der Daten an das bewusste Gehirn weiter. Sie können dies bis zu einem gewissen Grad steuern: Zum Beispiel sagt Ihr bewusstes Gehirn dem Nucleus geniculatus lateralis gerade: „Schick mir nur Informationen aus dem zentralen Blickfeld, konzentriere dich auf die getippten Wörter in der Mitte des Blickfeldes, bewege dich von links nach rechts, damit ich sie lesen kann.“ Unterbrechen Sie das Lesen für eine Sekunde und versuchen Sie, ohne Ihre Augen zu bewegen, zu sehen, was sich in Ihrem peripheren Blickfeld befindet. Vor einer Sekunde haben Sie das Objekt rechts oder links vom Computermonitor nicht „gesehen“, weil das periphere Sehen nicht an das bewusste Gehirn weitergeleitet wurde.

![]()

Wenn Sie sich konzentrieren, auch ohne die Augen zu bewegen, können Sie zumindest erkennen, dass das Objekt dort ist. Wenn Sie es jedoch deutlich sehen wollen, müssen Sie ein weiteres Gehirnsignal an das Auge senden, um den Kegel der visuellen Aufmerksamkeit auf dieses Objekt zu verlagern. Beachten Sie auch, dass Sie nicht gleichzeitig den Text lesen und die Objekte in der Peripherie sehen können – das Gehirn kann nicht so viele Daten verarbeiten.

Das Gehirn ist noch nicht fertig, wenn das Bild den bewussten Teil (den sogenannten visuellen Kortex) erreicht hat. Dieser Bereich ist eng mit den Gedächtnisbereichen des Gehirns verbunden und ermöglicht es, Objekte auf dem Bild zu „erkennen“. Wir alle kennen diesen Moment, in dem wir etwas sehen, aber für ein oder zwei Sekunden nicht erkennen, was es ist. Nachdem wir es erkannt haben, fragen wir uns, warum wir es nicht sofort erkannt haben. Das liegt daran, dass das Gehirn den Bruchteil einer Sekunde braucht, um auf die Speicherdateien für die Bilderkennung zuzugreifen. (Wenn Sie das noch nicht erlebt haben, warten Sie einfach ein paar Jahre. Sie werden es erleben.)

In Wirklichkeit (und das ist sehr offensichtlich) ist das menschliche Sehen Video, nicht Fotografie. Selbst beim Betrachten eines Fotos nimmt das Gehirn mehrere „Schnappschüsse“ auf, während es den Fokus über das Bild bewegt und sie zu dem endgültigen Bild, das wir wahrnehmen, zusammensetzt. Schauen Sie sich ein paar Minuten lang ein Foto an, und Sie werden feststellen, dass Ihr Auge unbewusst über das Bild gewandert ist, sich einen Überblick verschafft hat, sich hier und da auf Details konzentriert hat und nach ein paar Sekunden einige Dinge erkannt hat, die auf den ersten Blick nicht offensichtlich waren.

Was ist der Punkt?

Nun, ich habe einige Beobachtungen gemacht, obwohl sie weit entfernt sind von der Frage „Welches Objektiv hat das dem menschlichen Sehen ähnlichste Sichtfeld?“. Diese Informationen haben mich dazu gebracht, darüber nachzudenken, was mich an manchen Fotografien so fasziniert und an anderen nicht so sehr. Ich weiß nicht, ob eine dieser Beobachtungen wahr ist, aber es sind interessante Gedanken (zumindest für mich). Sie beruhen alle auf einer Tatsache: Wenn mir ein Foto wirklich gefällt, verbringe ich eine oder zwei Minuten damit, es zu betrachten, es mit meinem menschlichen Sehvermögen abzutasten, die Details zu erfassen oder mich vielleicht über die nicht sichtbaren Details zu wundern.

Fotografien, die mit einem „normalen“ Blickwinkel (35 mm bis 50 mm) aufgenommen wurden, scheinen ihren Reiz unabhängig von ihrer Größe zu behalten. Selbst Bilder in Webgröße, die mit dieser Brennweite aufgenommen wurden, behalten die Essenz der Aufnahme. Die untenstehende Aufnahme (mit 35 mm aufgenommen) weist in einem großen Bild viel mehr Details auf, aber die Essenz ist auch in einem kleinen Bild offensichtlich. Vielleicht ist es für das Gehirn einfacher, ein Bild zu erkennen, das es in seinem normalen Sichtfeld sieht.

![]()

Das obige Foto zeigt etwas anderes, das ich mich schon immer gefragt habe: Liegt unsere Faszination und Liebe für die Schwarz-Weiß-Fotografie darin begründet, dass dies eine der wenigen Möglichkeiten ist, wie die dichten Zapfenrezeptoren (nur Farbe) in unserer Makula gezwungen werden, ein Graustufenbild an unser Gehirn zu senden?

Vielleicht gefällt es unserem Gehirn, nur Farbtöne und Texturen zu sehen, ohne dass Farbdaten die schmale Bandbreite zwischen Auge und Gehirn verstopfen.

Wie „normalwinklige“ Aufnahmen sehen auch Tele- und Makroaufnahmen in kleinen Abzügen oder JPGs in Webgröße oft großartig aus. Ich habe einen 8 × 10-Abzug eines Elefantenauges und einen Makroabzug einer Spinne in ähnlicher Größe an meiner Bürowand, die selbst von der anderen Seite des Raumes großartig aussehen. (Zumindest sehen sie für mich großartig aus, aber Sie werden feststellen, dass sie in meinem Büro hängen. Ich habe sie an ein paar anderen Stellen im Haus aufgehängt und wurde taktvoll darauf hingewiesen, dass „sie nicht zu den Wohnzimmermöbeln passen“, also sehen sie vielleicht nicht für jeden so toll aus.)

Es gibt keine großartige Komposition oder andere Faktoren, die diese Fotos für mich attraktiv machen, aber ich finde sie trotzdem faszinierend. Vielleicht liegt es daran, dass mein menschliches Sehvermögen selbst bei einer kleinen Größe Details auf dem Foto erkennen kann, die ich beim Betrachten eines Elefanten oder einer Spinne mit bloßem Auge niemals sehen könnte.

![]()

Wenn ich dagegen eine gute Weitwinkel- oder Landschaftsaufnahme mache, mache ich mir kaum die Mühe, eine Grafik in Webgröße zu veröffentlichen oder einen kleinen Abzug zu machen (und ich werde für diesen Artikel nicht damit anfangen). Ich will es GROSS gedruckt haben. Vielleicht, damit mein menschliches Sehvermögen das Bild überfliegen und die kleinen Details erkennen kann, die bei einer Verkleinerung völlig verloren gehen. Und jedes Mal, wenn ich einen großen Abzug mache, selbst von einer Szene, die ich schon ein Dutzend Mal gesehen habe, fallen mir auf dem Foto Dinge auf, die ich nie gesehen habe, als ich persönlich vor Ort war.

Vielleicht liefert das „Video“, das mein Gehirn beim Scannen des Abzugs macht, viel mehr Details, und ich finde es ansprechender als die Komposition des Fotos, wenn es klein gedruckt ist (oder die ich gesehen habe, als ich tatsächlich vor Ort war).

Und vielleicht erklärt das unbewusste „Scannen“, das mein Blick über ein Foto macht, warum Dinge wie die „Drittel-Regel“ und der selektive Fokus mein Auge auf bestimmte Teile des Fotos lenken. Vielleicht haben wir Fotografen einfach herausgefunden, wie das Gehirn Bilder verarbeitet, und haben uns das durch praktische Erfahrung zunutze gemacht, ohne die ganze Wissenschaft zu kennen.

Aber ich denke, meine einzige wirkliche Schlussfolgerung ist diese: ein Foto ist NICHT genau das, was mein Auge und mein Gehirn am Ort des Geschehens gesehen haben. Wenn ich eine gute Aufnahme mache, ist es etwas anderes und etwas Besseres, wie Winogrand in den beiden obigen Zitaten sagte, und auch in diesem Zitat:

Du siehst etwas, das passiert, und du machst dich daran zu schaffen. Entweder du bekommst, was du gesehen hast, oder du bekommst etwas anderes – und was davon besser ist, druckst du.

Über den Autor: Roger Cicala ist der Gründer von LensRentals. Dieser Artikel wurde ursprünglich hier veröffentlicht.

Bildnachweis: my eye up close by machinecodeblue, Nikh’s eye through camera’s eye from my eyes for your eyes 🙂 by slalit, Schematic of the Human Eye by entirelysubjective, My left eye retina by Richard Masoner / Cyclelicious, Chromatic aberration (sort of) by moppet65535